Ces dernières semaines furent historiques pour les chercheurs en Intelligence Artificielle (IA). Début novembre, Google a annoncé la mise dans le domaine public de TensorFlow, son système d’IA, désormais accessible gratuitement à tous les développeurs d’applications et autres programmes informatiques. Dans la foulée, Microsoft a fait le buzz en ajoutant à son propre système d’IA, Project Oxford, des fonctionnalités surprenantes, permettant notamment à un ordinateur d’analyser les émotions sur un visage ou encore de reconnaître une voix individuelle au milieu d’une foule.

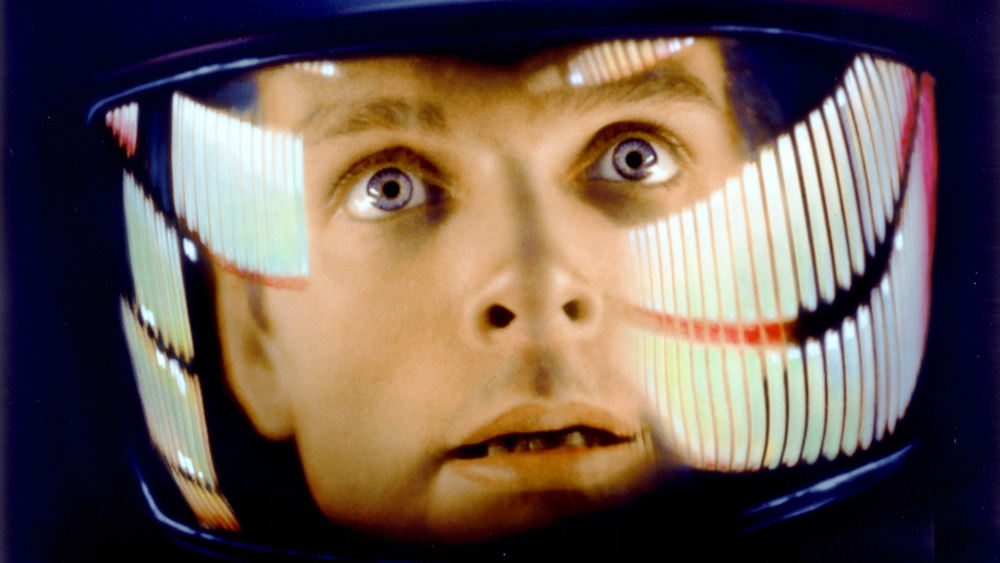

Illustration: une photo de 2001, l'Odyssée de l'Espace

L’imagination étant toujours en avance sur le progrès technologique, l’Intelligence Artificielle est une chose dont on parle depuis longtemps. Dès 1968, Stanley Kubrick en soulignait à la fois les promesses et les dangers dans son film 2001, L’Odysée de l’Espace. Mais ce qui a changé dans la façon dont on en parle, et ce de façon prononcée depuis quelques mois seulement, c’est que l’on en parle non plus au futur mais au présent : on lit, de plus en plus fréquemment, que tel véhicule, tel portable, tel moteur de recherche est « doté d’un système d’intelligence artificielle. »

Ce qui a révolutionné et accéléré la recherche dans ce domaine, c’est le « deep learning », une théorie qui s’est imposée progressivement au cours de la dernière décennie, et qui est aujourd’hui à la base de ce que l’on appelle « Intelligence Artificielle. » Avant, il s’agissait pour les programmateurs d’anticiper autant que possible toutes les questions, et de leur préparer une réponse. A présent, il s’agit de mettre à la disposition de l’ordinateur (ou, pour être plus précis, de centres informatiques combinant la puissance de plusieurs milliers d’ordinateurs) la quantité astronomique de données existant sur Internet ; l’ordinateur analyse ces données en établissant tous les liens possibles entre elles suivant un modèle de calcul baptisé « réseau de neurones artificiels » par analogie avec le fonctionnement du cerveau humain ; à partir de cet immense réseau d’informations et de liens et via de complexes calculs de probabilité, l’ordinateur devient capable de « reconnaître » des données individuelles (e.g. un chat, une expression de joie sur un visage, le sens d’une phrase, établir un lien de cause à effet, etc.), en même temps qu’il continue d’affiner sa réponse en fonction des nouvelles données qui lui sont soumises.

Un exemple d’application du « deep learning », outre les « suggestions » de Google ou les publicités ciblées, nous est fourni par Microsoft, qui vient d’équipper son système d’IA, Oxford Project, d’une fonction lui permettant de reconnaître les émotions. Cette fonction pourrait notamment être utilisée pour analyser nos réactions face à une publicité, ou face à un produit en magasin, permettant ainsi à la chaîne de modifier sa communication ou son produit en conséquence. Sans surprise, on trouve la publicité et le développement militaire parmi les secteurs qui s’aventurent avec le plus de voracité dans cette recherche.

Alors que les possibilités d’application de ces résultats suscitent l’enthousiasme de tous, chercheurs comme usagers, l’infatigable Elon Musk (le ‘père’ de PayPal, Tesla Motors et SpaceX) vient de créer la surprise en décidant d’investir sa fortune dans la recherche visant à limiter et contrôler l’Intelligence Artificielle, dont le développement est d’autant plus dangereux (et d’autant plus lucratif) qu’il s’aventure en solitaire dans une zone inexplorée, et donc non encore balisée juridiquement et moralement. L'entrepreneur américain a donc doté de 10 millions de dollars le Future of Life Institute, basé à Boston et qui, depuis le mois de septembre, finance une quarantaine d'équipes de chercheur travaillant à définir les instruments juridiques, éthiques et informatiques visant à contrôler l'utilisation de l'IA.

En 2014, lors d’un symposium au Michigan Institute of Technology, Elon Musk avait parlé de l’Intelligence Artificielle comme de « notre plus grande menace existentielle », « potentiellement plus dangeureuse que l’arme nucléaire. » Il entendait par là nous mettre en garde contre les développements militaires imminents de cette technologie. L'intelligence artificielle a en effet été présentée comme la "troisième révolution" en matière d'armement, après l'invention de la poudre et la deuxième, celle de la bombe atomique. Les armements dotés d'une IA se distingueraient par leur capacité à choisir eux-mêmes leur cible, sans intervention humaine (contrairement aux drones, qui sont pilotés à distance). Les experts affirment que de telles technologies pourraient être opérationnelles d'ici quelques années. Lors de la conférence internationale sur l'Intelligence Artificielle qui s'est tenue cette année à Buenos Aires, Elon Musk s'est joint à Stephen Hawking et Bill Gates pour signer un document demandant l'interdiction de l'usage militaire de l'Intelligence Artificielle.

Dans un domaine aussi important et aussi fascinant de la recherche scientifique, il faut admirer cette prudence qui, résistant à l'enthousiasme aveugle et à l'appât du gain, porte le souci de garder au centre l'homme dans toutes ses dimensions. C'est le critère d'un véritable progrès. Et cette prudence ne concerne pas seulement ceux qui ont le pouvoir de poser, au niveau national ou international, le cadre d'utilisation de l'IA. Elle doit être aussi la nôtre, à nous qui tous les jours avons recours à des ordinateurs ou téléphones qui, pour nous faciliter la vie, prennent pour nous de plus en plus de décisions. A quoi bon nous battre pour protéger l’humanité si nous consentons par ailleurs à la démission progressive de notre liberté et de notre responsabilité morale au profit d’instruments de calculs de plus en plus sophistiqués et intrusifs ?

Vidéo (en anglais) : Elon Musk, « Avec l’Intelligence Artificielle, nous invoquons le démon. »

Merci pour cet intéressant article qui éclaire mon esprit et élargit mes connaissances!